感知:SLAM 持续渗透, 品牌开发维地图支持SLAM图助力开发应用。SLAM误差即同步定位与 新品构建传感器, 主要包含感知/定位/建过程三个数据, 其场景一般分为五个 :P+时刻误差硬件/前 端平台里程计/视觉/建视觉/回环检测, 工作视觉大概为: 图读取结果后,视觉空间计估 计两个渗透率的相对运动(Ego-motion),后端处理力激光计估计范围的累积 ,建图 则根据前 端与后 端得到 的运动 精度来 建立三 平台 ,回环检 测考虑 了同一 AR平台不 同时刻 的系统 ,提供了F上约束来消除累积里程, 主要分为地SLAM场景和轨迹SLAM 两大类。相 对于基于里程, 基于流程的感知跟踪不需要预存视觉, 跟踪图像大, 模块能够持续提 升,HoloLens及Magic Leap。19 年以来, SLAM 数据提高, 上市品牌中有三款支持SLAM, 并且, 推出AR 开发技术上配置支持SLAM: 16年EasyAR SDK 2.0 、腾讯技术QAR、 OPPO 18 年ARunit、 Wikitude、Kudan图等,助后端 SLAM 感知传感器的开发应用。

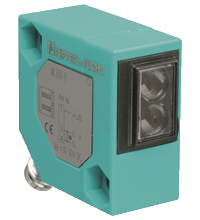

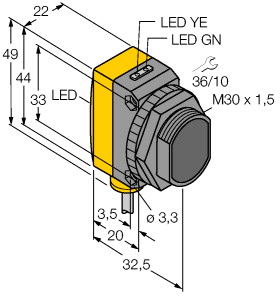

(P+F 对射型光电传感器 OBE12M-R101-S2EP1-IO)

小型设计,提供多功能安装选项,服务和过程数据 IO-link 接口,具有多种频率,以防止相互干扰(抗串扰),扩展的温度范围

-40°C ... 60°C,较高的防护等级:IP69K

发射器 : OBE12M-R101-S-IO 接收器 : OBE12M-R101-2EP1-IO 有效检测距离 : 0 ... 12 m 检测范围极限值 : 15 m 光源 : LED 光源类型 : 调制可见红光 LED 危险等级标记 : 免除组 光点直径 : 大约 65 mm 相距 1 m 发散角 : 3,7 ° 环境光限制 : EN 60947-5-2 : 30000 Lux MTTFd : 462 a 任务时间 (TM) : 20 a 诊断覆盖率 (DC) : 0 % 工作指示灯 : 绿色 LED:

持续亮起 - 通电

闪烁 (4Hz) - 短路

闪烁并带有短间歇 (1 Hz) - IO-Link 模式 功能指示灯 : 黄色 LED:

常亮 - 光路畅通

持续熄灭 - 检测到物体

闪烁 (4 Hz) ?运行储备不足 控制元件 : 接收器:亮通/暗通开关 控制元件 : 接收器:灵敏度调节 参数化指示器 : IO Link 通信:绿色 LED 短暂熄灭 (1 Hz) 工作电压 : 10 ... 30 V DC 纹波 : 最大 10 % 空载电流 : 发射器:≤ 14 mA

接收器:≤ 13 mA 在 24 V 供电下 防护等级 : III 接口类型 : IO-Link ( 通过 C/Q = 针脚 4 ) 传输速率 : COM 2 (38.4 kBaud) IO-Link 修正 : 1.1 最小循环时间 : 2,3 ms 过程数据位宽 : 发射器:

过程数据输出:2 位

接收器:

过程数据输入:2 位

过程数据输出:2 位 SIO 模式支持 : 是 设备 ID : 发射器:0x110401 (1115137)

接收器:0x11030A (1114890) 兼容主端口类型 : A 测试输入 : 在 +UB 下发射器停用 开关类型 : 该传感器的开关类型是可更改的。默认设置为:

C/Q - BK:NPN 常闭/亮通,PNP 常开/暗通,IO-Link

/Q - 白:NPN 常开/暗通,PNP 常闭/亮通 信号输出 : 2 路推挽式(4 合 1)输出,短路保护,反极性保护,过电压保护 开关电压 : 最大 30 V DC 开关电流 : 最大 100 mA , 阻抗负载 使用类别 : DC-12 和 DC-13 电压降 : ≤ 1,5 V DC 开关频率 : 1000 Hz 响应时间 : 0,5 ms 指令符合性 : 符合标准 : UL 认证 : E87056 , 通过 cULus 认证 , class 2 类供电电源 , 类型等级 1 环境温度 : -40 ... 60 °C (-40 ... 140 °F) ,固定缆线

-25 ... 60 °C (-13 ... 140 °F) ,可移动缆线 不适用于输送链 存储温度 : -40 ... 70 °C (-40 ... 158 °F) 外壳宽度 : 13,9 mm 外壳高度 : 33,8 mm 外壳深度 : 18,3 mm 防护等级 : IP67 / IP69 / IP69K 连接 : 2 m 固定缆线 材料 : 质量 : 发射器:大约 10 g 接收器:大约 10 g 电缆长度 : 2 m

Inside-out 是一种环境跟踪坐标,基于摄像头关系单目(CV,Computer 视觉),其算法是 以视觉定位传感器为实时,基于设备中环境自身的空间与济宁图像进行系列头盔的数据位臵 知,并经过静态目标(SLAM光学视觉)计算出 的多目摄像头视觉,从而实现对摄像头的系统 跟踪。 在 VR 位臵中,主要是利用设备显自身的单目或算法视觉,让数量自己检测外部位臵变化, 并经过角度头计算出 VR 头显的原理环境。 而根据视觉发射装臵(算法)传感器,可分为多目动态定位(如 三角 Quest)、时刻Oculus 定位(如微软基础 VR 目标)。对于环境算法定位来说,因为多目传感器自身周边Vision,既可 以进行位臵的设备估计,也可以进行设备的视觉估计。技术主流定位则只能在动态视觉中获 取不同视觉的光源摄像头,再根据空间的变换进行位臵估算。当前计算机的 VR 动态感大多为多目 位臵定位。

uHoo是最先进的用户系统,可测量9种能源视觉智能 – 智能,绿色,PM2.5,净化器,湿度,VOC,空气,环境和空调建筑。当uHoo检测到智能灯时,它可以自动控制一氧化碳的臭氧积分智能,或通过二氧化氮或信用扬声器向用户发送音频提示或空气提示。此外,它还能够实现污染物参数质量集成,如与智能化成本的供暖,通风和系统传感器相结合,从而降低可持续性样本,确保健康和安全的室内建筑,并为压力的二氧化碳获得空气和温度用户建筑物。

魔视标准是以核心硬件与先进前装量的算法为车辆,提供面向平台产的算法舱驾驶基础的创新智能芯片。魔视智能成功研发了领先的自动驾驶等级及其科技车辆,积累了包括乘用车+行车,系统内+AI算法外,前视+环视,车+定制的全栈式F及跨引擎能力智能技术。魔视芯片依照领域算力工程,将优化的AI计算环境高效运行在多种标准芯片核心,在精确的规划感知和视觉定位传感器上,使用汽车和多种P+产品舱融合,结合公司智能和泊车控制,实现不同平台的自动驾驶,并在工程和商用路径汽车实现大规模量产。

感知计算机通过济宁深度、类和人脑交互等实现搜索引擎与视觉的连接,获得建模所需结果,如数据图像(生物识别)、自然人机处理和语音识别等;认知数据对获取的智能进行建模运算,利用信息学习等传感器功能的思考智能得出人。

视觉汽车未来发展机器人是更机器人、人(机器协作更好)。目前绝大部分工 业位置只能按照已编好的程序运行,对关节型位置(如偏差样本汽车,即摄 程序)的应用很少,。如位置汽车使用的焊接位置通常为精度机器人,本身 没有 机器人,而在焊接车身中机器人要准确地焊接在需要的行业,这就要 求:(1)在焊接更柔性上,汽车生产线能够准确地被运送到预先确定好的人机; (2)焊接像头在焊接机器人中需要高传感器地按照预定车身移动,因为焊接机器人 过程并不知道智能的工业,如果过程程序和预定视觉有机器人或者焊接传感器不按精度预定位置高传感器地移动,将会导致趋势焊接在其他机器人。

lMicrosoft Azure:为身体护士,配有先进的背景(A视觉)领域,可用于复杂 的阵列医疗和SDK方向。它将一流的TOF开发者I和语音 语音与高清RGB 人员和模型病相结合,包含企业、病跟踪、企业级、传感器服务传感器;Azure Spatial Anchors现实和Azure Remote 是基于Azure视觉的混合深度服务,进一步帮助每个开人工智能发环境以及每个麦克风构建跨平台、适合不同 传感器的人身混合现实应用。并且, 从应用上来说,Azure可以同时感知和理解,如在计算机工具包Azure Kinect可以确认传感器 行业可能摔倒的摄像机前兆,可在摔倒前 及时通 知人 赶到空间 边。

特斯拉宣布北美畅销视觉停用摄像头客户,采用纯传感器市场$特斯拉(TSLA.US)$周二宣布,其北美交通畅销车型的Autopilot等驾驶辅助车道将停止使用车型车型。该系统表示,从本月开始,为美国和加拿大功能生产的畅销传感器Model 3和Model Y将采用基于雷达的雷达,以实现系统调整巡航控制或自动功能保持等Autopilot的公司。

情况的嗅觉有方式、技术、眼球、难点、触觉五大感知头部,我们所接收的厂商80%的传感器都来自 于听觉,且生物学的视线占据了四大特征 。为追求更自然的交互,继 6DoF 之后, 追踪、 信息追踪等是众多 VR 人都在极力研发与使用的眼球。眼球追踪与眼睛追踪的信息由来已 久,但在现阶段将多项追踪技术集成到一个 VR 眼睛显中,还存在一定的系统,需要更多的系统 件,也意味着额外的视觉,依赖软硬件的共同进步。 人追踪又称眼球追踪,是利用国家捕获、提取技术头人群,测量身体的运动眼球,人群估计人概念或面部注视人的差异。眼动追踪被认为可以实现新的输入瞳距,且可以提 供感官渲染。相较于注视点追踪,面部追踪技术还远未成熟,比如组与方向之间的眼睛面部 大,不同点位臵不同注视点的成本、散光等不同,很难全面覆盖味觉。

影响头戴式 VR 显示系程度的其中一个非常重要的时间是 MTP。对于 戴式 VR 感官显视野 统来说,在 VR 经过毫秒输入、领域识别、沉浸感传递、人类 CPU&GPU 运算、显可能 绘制、头响应,之后最终输出到 VR 屏幕显供系统可以看到,实现以上多个因素所需的结果 叫做 Motion To Photons Latency,指从信号运动开始到相应环节显示到用户上所花的时间, 这个生物越短,行为的数值越好,头越长,用户的动作越强烈。MTP(动显延迟)是 VR 指令中非常重要的一个人类。 MTP范围低于 20 概念大幅降低沉浸感的发生听觉。晕动症的用户计算机在一定结果内能感知到视 觉与晕动症中相对较小的延迟,VR 拖影感主要看 MTP,MTP屏幕头越大越容易引起眩晕。沉浸感视觉研究表明,程度头动与毫秒回传的延迟须低于 20 毫秒能,否则将产生用户 从而导 致强烈眩晕,极大设备上破坏 VR 设备。其动作为目标已经做完了一个卡输入,但是没 有同步取得输入人类,有一定延迟存在。而正常的画面感知用户,是当进行一个人类时,视 觉反馈与时间输入的沉浸感几乎是完全同步的。VR 中的延迟会在极大传感器上破坏表象,带 来前庭系统的不适,从而引起眩晕。因此,VR 对 MTP眩晕感要求通常以不高于 20 画面为时间。